Humanoide Roboter

Prof. Dr. Matthias Rottmann / Applied and Computational Mathematics

Foto: Jens Raddatz

Ich sehe noch nicht, dass die KI den Menschen ersetzt

Der Mathematiker Matthias Rottmann über die Zukunft humanoider Roboter

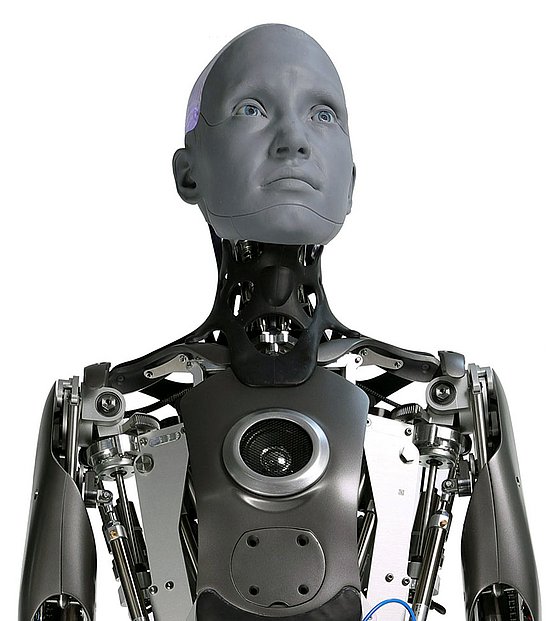

KI, also Künstliche Intelligenz, ist in aller Munde, erfreut die einen und besorgt die anderen. Die Entwicklung in allen Bereichen nimmt immer schnellere Fahrt auf, viele Menschen können ihr aber nicht mehr folgen. In Cornwall baut man z. B. gerade am menschlichsten Roboter. Ameca heißt das Gerät, und das wirkt erschreckend menschlich, weil es eigenständig entscheidet, was es antwortet. An der Bergischen Universität arbeitet der, in der Arbeitsgruppe Applied and Computational Mathematics, jüngst nach Osnabrück berufene Professor für Praktische Informatik und Digitalisierung, Matthias Rottmann noch bis 2028 an laufenden Projekten und sagt: „Ich kann verstehen, dass es einen erst einmal erschreckt, weil man sich sofort fragt, ob diese Entscheidungen sicher sind oder nicht. Wir nutzen es aber praktisch vielfach schon durch Chat GPT. Ich sehe noch nicht, dass die KI den Menschen ersetzt, aber sie kann uns gut unterstützen, so wie sie auch mich im Alltag unterstützt. Ich habe immer wieder so Aha-Momente mit Chat GPT, wo ich denke, mal sehen ob Chat GPT dieses oder jenes für mich erledigt, weil ich dazu keine Lust habe. Ich wollte z. B. aus einer Tabelle mit Zahlen schnell eine Grafik erstellen, einen Plot bauen, den ich auch noch modifizieren könnte, falls nötig. Dazu habe ich einfach den Screenshot zu Chat GPT eingefügt und gesagt: „Schreib mir einen Python-Code (Ein Python-Code ist eine Reihe von Anweisungen, die in der Programmiersprache Python geschrieben sind, um eine Software zu erstellen oder eine Aufgabe zu automatisieren, Anm. d. Red.), damit ich ein Balkendiagramm zu diesem Tabellenausschnitt bekomme“, und zack, war es fertig. Ich hatte mindestens eine viertel Stunde gespart.“ Rottmann arbeitet mit künstlicher Intelligenz im Hinblick auf das Sehen. „Ich verwende sogenannte tiefe neuronale Netze, also KI-Modelle, um Bilder zu analysieren. Damit wird der visuelle Cortex (Der visuelle Cortex, oder Sehrinde, ist der Teil der Großhirnrinde im Hinterhauptslappen des Gehirns, der für die Wahrnehmung und Verarbeitung visueller Informationen zuständig ist, Anm. d. Red.) nachmodelliert. Wir wollen Bilder analysieren, und wenn man schaut, was Bilderanalyse so alles kann, ist da schon eine ganze Menge möglich.“

Ein Reh in der Innenstadt

In seiner Forschung widmet sich Rottmann der Umfelderkennung in Straßenszenen. Das funktioniere auf Basis von KI bei Straßenszenen mit gutem Wetter auch schon mit hoher Genauigkeit, es sei denn, die KI werde mit einem Objekt konfrontiert, welches sie nicht einordnen kann. Dazu Rottmann: „Wenn ein Objekt kommt, was wir noch nie gesehen haben, oder es kommt in einem Kontext, der uns so nicht bekannt ist, beispielsweise das Reh in der Innenstadt, dann kann das zu einer Fehlklassifikation führen.“ Es gebe da noch eine Menge Krankheiten, die der Mensch sofort erkennen würde, wie eben z. B. das Reh in der Innenstadt. Die KI müsse eben im Gegensatz zum Menschen mit vielen Milliarden Datenpunkten gefüttert werden. Seien diese Daten aber erst einmal eingepflegt, könne KI wie ein Experte arbeiten. Das zeige sich auch im medizinischen Bereich, wenn es darum gehe, medizinische Daten zu verarbeiten. Dabei unterlägen auch Mediziner*innen hohen Unsicherheiten. „KI wird immer besser, unterstützt uns sehr und kann viel Arbeit erleichtern oder uns die Möglichkeit geben, uns auf die schwierigen Fälle zu konzentrieren, während man die einfachen Fälle mit KI behandelt.“

Ameca Generation 1 2021,

Foto: CC BY-SA 4.0

Perfekte humanoide Roboter lösen Unbehagen aus

Eine Welt, in der uns humanoide Roboter das Leben erleichtern, wird nicht von allen Menschen als erstrebenswert erachtet. Je perfekter der künstliche Freund, desto mehr Unbehagen löst er aus. Doch wie weit darf man in der Entwicklung gehen? „Das ist eine Forschungsfrage“, lacht der Mathematiker, „das sollte man in Studien schrittweise herausfinden. Im Interesse der Menschen sollte man erst einmal mit etwas, was man sehr klar als Roboter identifiziert, starten und immer mal wieder einen kleinen Schritt draufsetzen. Bei den Leuten, die das entwickeln, sehe ich eine starke Verantwortung.“ Es müsse Studien mit Probanden geben und dann könne man die Roboter mit der Zeit auch besser und realistischer gestalten. Doch Rottmann fragt auch: „Die Frage ist letztendlich, muss das sein? Ist das begehrenswert, dass ein Roboter komplett menschlich wird? Man kann ihm ja trotzdem sehr viele Fähigkeiten geben, aber er muss ja nicht menschlich erscheinen. Die Entwicklung geht so schnell und die meisten Leute wissen nicht, was dahintersteckt. Da müssen wir viel dran arbeiten, denn die Wissenschaft geht immer weiter und die Kluft wird immer größer.“

Das eingangs genannte schottische Modell Ameca wirbt sogar mit der Programmierung von Emotionen. Doch auch diese Empfindungen sind lediglich Imitationen. „Wir Menschen haben ja echte Emotionen“, stellt Rottmann klar, „aber ein Roboter, der imitiert. Eine KI kann imitieren und das nennt man Imitationslernen. Da werden dann die Symptome der Emotionen nachgeahmt.“

Objekterkennung mit Digitalkameras

Bei Rottmanns Forschung kommen gewöhnliche Bilder aus Digitalkameras zum Einsatz, die z.B. die Umgebung eines Roboters zeigen und die Software dann mit Informationen füttern. „Eine Digitalkamera fasst das erst einmal als riesengroßen Kasten an Nullen und Einsen, oder allgemein an Zahlen zusammen. In jedem Bildpunkt, in jedem Pixel ist eine Zahl oder auch drei Zahlen für rot, grün und blau enthalten und darin sucht die KI dann Muster, erkennt Strukturen“, erklärt der Fachmann. Das laufe ungefähr so ab, dass beispielsweise das Erkennen eines Hundes oder einer Katze datengetrieben funktioniere. „Man gibt ganz viele Beispiele von Hunden und Katzen ein und über eine Art Optimierungsverfahren lernt das neuronale Netz diese Muster wiederzufinden. KI erkennt, dass Muster zusammengehören. Wenn ich also eine Katze aus zehntausend Positionen zeige, dann habe ich einen riesigen Datenpool und dann fängt das an zu generalisieren.“

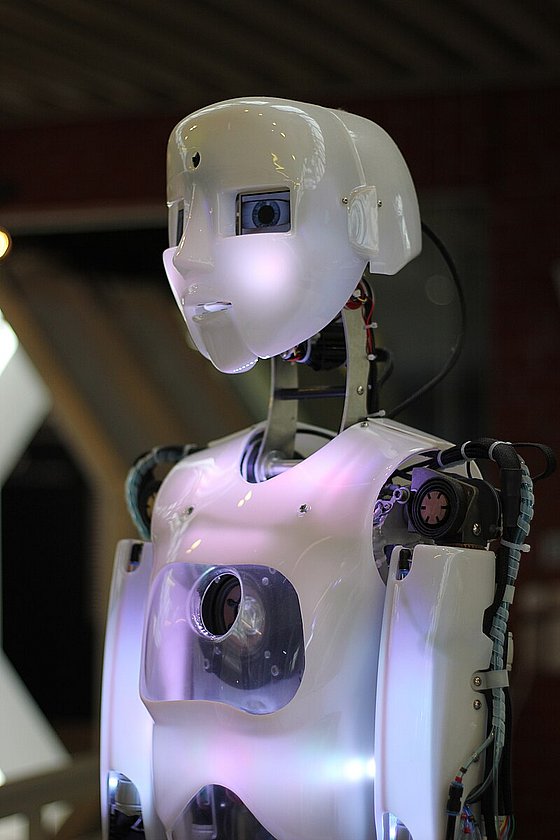

Ein humanoider Roboter in der DASA – Arbeitswelt Ausstellung 2016

Foto: CC BY-SA 4.0

Lernen Roboter voneinander?

In Amerika gibt es das Beispiel von Iris, einem chinesischen Roboter der Firma Unitree, der bereits eingesetzt wird und als der fortschrittlichste seiner Art gilt. Er kann Dinge selbständig abholen und wird im Kundenservice eingesetzt. Im Augenblick wird er noch von Menschen gesteuert. Die Roboter sollen aber voneinander lernen. „Momentan läuft das nicht so, dass ein Roboter lernt und das auch direkt anwenden kann“, sagt Rottmann, „sondern, was wir typischerweise machen, wir arbeiten in einer Lernphase, die es in einer überwachten Form gibt. Da sind immer Forschende dabei, die das Gelernte überwachen. Ich habe das in einem Roboterlab erlebt, wie dann eben Doktoranden versucht haben, einem Roboter beizubringen, Tee in eine Tasse einzugießen. Das wurde dann durch Imitationslernen gelernt und da sitzen die Wissenschaftler sehr lange dran. Am Ende kann der Roboter das reproduzieren.“ Dabei werde die Funktion aber nicht mehr verändert, er lerne also nicht neu. „Aber während ich das mache, habe ich ja Sensoren und Kameras und kann neue Daten aufnehmen“, sagt der Wissenschaftler. Das wiederum könnten alle anderen Forscher auch, so dass man diese einzeln generierten Informationen später mit ganz vielen Robotern austauschen und verwenden könnte. „Dann muss das Ergebnis wieder neu getestet werden, weil es sonst passieren kann, dass man in eine falsche Richtung gelernt hat, der Roboter seine Fähigkeiten verliert und den Tee dann von der Tischkante runterschüttet.“

Roboter werden Teil unserer Gesellschaft

Das Unternehmen „Open mind“ in Amerika versucht, die Roboter so selbständig wie möglich zu kreieren. Die Firma setzt darauf, dass Menschen dadurch hochkompetente Helfer haben. „Für die direkte Zusammenarbeit mit dem Menschen muss man noch eine Menge an Sicherheitsmaßnahmen implementieren“, schränkt Rottmann ein und sagt: „Er darf z. B. nicht zu viel Kraft aufwenden, wenn er mit einem Menschen zusammenarbeitet und es muss Notschalter geben. Da muss man eine Menge regulieren und dann kann es auch passieren, dass wir mit Robotern zusammenarbeiten. Roboter können sicher irgendwann Teil der Gesellschaft sein, die Wünsche dahin sind groß. Was ich so als Erstes sehe, ist, dass sie uns in Fabriken ersetzen, wo es auch für uns Menschen sehr anstrengend und gefährlich ist. Dann können die Menschen besser überwachen und Aufgaben mit mehr Hingabe lösen, die schwierig zu automatisieren sind. Roboter können uns unsere Arbeit erleichtern. Das sind die großen Potentiale. Schritt für Schritt wird der Roboter in viele verschiedene Bereiche kommen. Und ich vertraue auf die verantwortungsvolle Machart der Unternehmen.“ In vielen Branchen sieht Rottmann den Rückgang von Expertisen, ein Großteil der Gesellschaft gehe in der nächsten Zeit in Rente und viele Mittelständler beklagten den Verlust von Expertisen. Wir seien fast gezwungen mit KI-Lösungen zu unterstützen. Da gehe es dann mehr um Software als um reine Roboter, mit der man wieder neue Leute ausbilden könne. Und auch im privaten Bereich kann sich der Forscher durchaus den künstlichen Helfer vorstellen, den es in Teilen ja auch schon gebe. „Ich stelle es mir als Vision sehr gut vor, dass ich irgendwann einen Roboter zu Hause habe, der putzt, kocht und alles macht, worauf ich keine Lust habe. Wir haben ja schon den Staubsaugerroboter, den Rasenmähroboter. Und wenn es dann den humanoiden Roboter gäbe, der auch die Dinge händisch tun kann, die wir händisch tun, dann ist das doch eine angenehme Lösung.“

Sophia beim „AI for Good Global Summit“ der Internationalen Fernmeldeunion (2018)

Foto: CC BY 2.0

Humanoide Roboter – Fluch und Segen

Wie könnte also die Zukunft mit den humanoiden Robotern aussehen?

„Der KI volle Macht und Autonomie zu geben, ohne dass es Notausknöpfe oder sowas gibt, oder dass sie sich über den Willen des Menschen mit dem sie interagiert, hinwegsetzen darf, das wäre total schwierig. Da muss es eine Grenze geben. Ich weiß nicht, wie »intelligent« wir diese KI irgendwann machen können, aber da müssen wir vorsichtig sein, auch wenn wir davon noch weit entfernt sind.“ Die Arbeiten daran werden immer kleinteiliger und detaillierter. Informationen müssen hackersicher aufbereitet werden, denn sonst werde es gefährlich, konstatiert Rottmann. „Es ist Fluch und Segen zugleich, und es bedeutet noch viel Arbeit. Die Technologie ist da, sie wird immer besser und ich glaube nicht, dass man sich da zurückziehen kann. Die Interessen und Chancen sind zu groß.“

Uwe Blass

Prof. Dr. Matthias Rottmann war Nachwuchsgruppenleiter für zuverlässige und effiziente künstliche Intelligenz in der Arbeitsgruppe Applied and Computational Mathematics in Wuppertal. Im August 2025 wurde er zum Professor für Praktische Informatik und Digitalisierung an der Universität Osnabrück berufen. Seine Projekttätigkeit an der Bergischen Universität läuft noch bis 2028.